[출처] http://en.wikipedia.org/wiki/Gradient_descent

* 기울기 계산

* 미분에 의해 계산

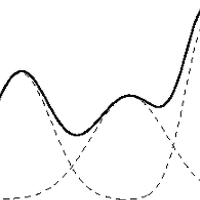

* 기울기가 - 이면, 하강 즉, local minima 을 향해감, 반면 + 이면 local maxima을 향해감(hill climbing)

* NN의 back-propagation에 적용됨, Hidden layer

* 에러가 최소가 되는 값을 찾아 최적의 해를 구함.

** 최적의 해를 보장하지 않음, local minima/maxima

* 두가지 형태 적용 ?[3]

** batch

** on-line

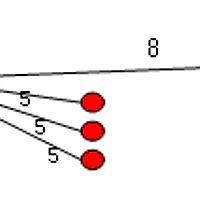

* x(i+1) = xi+alpha*미분(xi) : maxima, = xi-alpha*미분(xi) : minima

** alpha는 learning rate

*** 다음 해로 갈 이동거리를 조절한다.

*** 좀 더 빨리 값을 얻기 위해서 기울기에 학습 비율(learning rate)을 곱하는 것이 일반적.

** x(i) 현재

** x(i+1) Next

Ref

[1] http://ko.wikipedia.org/wiki/%EA%B2%BD%EC%82%AC_%ED%95%98%EA%B0%95%EB%B2%95

[2] http://www.aistudy.com/math/gradient_descent.htm

[3] http://www.whydsp.org/14

'Research > ML' 카테고리의 다른 글

| Machine Learning (Regularization) (1) | 2014.12.15 |

|---|---|

| 자연어 기계학습의 혁명적 진화 - Word2Vec에 대하여(펌) (0) | 2014.11.20 |

| Probabilistic Latent Semantic Analysis, PLSA (0) | 2014.07.03 |

| Gaussian Mixture Model (0) | 2013.11.06 |

| [링크] 자세한 KMeans 초기값 설정 개념 (0) | 2013.10.28 |